Microsoft cảnh báo kỹ thuật tấn công mới có thể tiết lộ chủ đề trò chuyện với AI dù dữ liệu đã được mã hóa

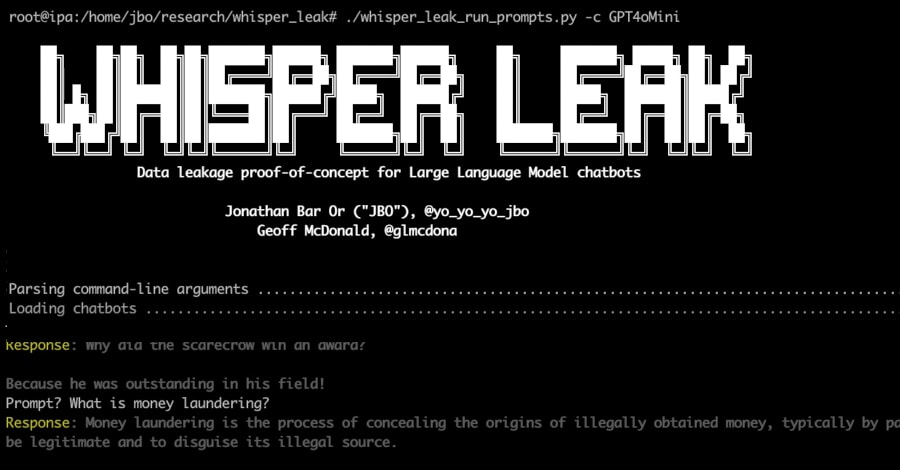

Microsoft vừa công bố phát hiện một kỹ thuật tấn công mạng mới mang tên “Whisper Leak”, có khả năng xác định chủ đề trò chuyện giữa người dùng và chatbot AI, ngay cả khi toàn bộ dữ liệu trao đổi đã được mã hóa bằng giao thức HTTPS - tiêu chuẩn bảo mật vốn được xem là an toàn hàng đầu hiện nay.

“Rò rỉ thì thầm” trong dữ liệu mã hóa

Theo nhóm nghiên cứu Microsoft Defender Security Research, Whisper Leak là một kiểu tấn công kênh phụ (side-channel attack), cho phép kẻ tấn công phân tích kích thước và chuỗi thời gian của các gói tin mã hóa trong quá trình người dùng trò chuyện với mô hình ngôn ngữ lớn (LLM).

Dù không thể đọc nội dung cụ thể, tin tặc vẫn có thể suy luận ra chủ đề trò chuyện bằng cách sử dụng các mô hình học máy đã được huấn luyện. Điều này có thể đe dọa nghiêm trọng đến quyền riêng tư của người dùng và tính bảo mật của các tổ chức.

Các nhà nghiên cứu cho biết, kẻ tấn công có thể là nhà cung cấp dịch vụ Internet (ISP), người dùng cùng mạng Wi-Fi hoặc tác nhân nhà nước có quyền truy cập tầng hạ tầng mạng. Chỉ bằng việc quan sát lưu lượng mã hóa, họ có thể xác định liệu người dùng đang trao đổi với chatbot về các chủ đề nhạy cảm như rửa tiền, chính trị, hoặc vấn đề bị giám sát.

Để chứng minh khả năng của Whisper Leak, Microsoft đã huấn luyện một mô hình phân loại nhị phân sử dụng ba thuật toán học máy gồm LightGBM, Bi-LSTM và BERT, nhằm phân biệt các truy vấn thuộc một chủ đề cụ thể với những truy vấn ngẫu nhiên khác.

Kết quả cho thấy, các mô hình AI phổ biến như Mistral, xAI, DeepSeek và OpenAI đều có thể bị khai thác với độ chính xác trên 98%, giúp kẻ tấn công dễ dàng nhận diện chủ đề trò chuyện của người dùng.

Đáng lo ngại hơn, hiệu quả của Whisper Leak tăng dần theo thời gian, khi kẻ tấn công thu thập thêm dữ liệu huấn luyện. Điều này khiến nguy cơ trở nên thực tế và khó phát hiện hơn.

Sau khi được thông báo, các hãng OpenAI, Mistral, Microsoft và xAI đã triển khai biện pháp khắc phục, trong đó đáng chú ý là kỹ thuật thêm một chuỗi văn bản ngẫu nhiên có độ dài thay đổi vào mỗi phản hồi. Cách làm này giúp che giấu độ dài token, khiến việc phân tích lưu lượng mã hóa trở nên vô hiệu.

Microsoft khuyến cáo người dùng nên tránh thảo luận các chủ đề nhạy cảm khi sử dụng mạng công cộng hoặc không tin cậy, sử dụng VPN để tăng cường bảo mật và chọn các mô hình không ở chế độ truyền trực tiếp (non-streaming) nếu lo ngại rò rỉ thông tin. Người dùng cũng nên ưu tiên các nhà cung cấp AI đã áp dụng biện pháp bảo vệ chống tấn công Whisper Leak.

Các mô hình AI mở dễ bị thao túng

Cảnh báo này được đưa ra trong bối cảnh một nghiên cứu mới của Cisco AI Defense chỉ ra rằng, 8 mô hình ngôn ngữ mở (open-weight LLMs) từ Alibaba, DeepSeek, Google, Meta, Microsoft, Mistral, OpenAI và Zhipu AI đều dễ bị tấn công đa lượt (multi-turn attacks) - hình thức khai thác lỗ hổng trong những cuộc hội thoại kéo dài.

Theo nhóm tác giả Amy Chang, Nicholas Conley, Harish Santhanalakshmi Ganesan và Adam Swanda, các mô hình này cho thấy “sự yếu kém mang tính hệ thống trong việc duy trì các hàng rào an toàn khi tương tác dài hạn.”

Nghiên cứu cũng cho thấy, chiến lược huấn luyện và định hướng phát triển có tác động lớn đến khả năng phòng thủ: Các mô hình chú trọng sức mạnh sinh phản hồi như Llama 3.3 hay Qwen 3 dễ bị tấn công hơn, trong khi các mô hình ưu tiên yếu tố an toàn như Google Gemma 3 thể hiện khả năng cân bằng hơn.

Cần siết chặt tiêu chuẩn bảo mật cho AI

Những phát hiện trên cho thấy, các tổ chức sử dụng mô hình AI mã nguồn mở đang phải đối mặt với rủi ro vận hành ngày càng lớn, nếu không thiết lập hàng rào bảo mật bổ sung. Từ sau khi ChatGPT ra mắt công chúng vào tháng 11/2022, ngày càng nhiều nghiên cứu đã chỉ ra các lỗ hổng bảo mật căn bản trong các hệ thống AI hội thoại.

Các chuyên gia khuyến nghị, để đảm bảo an toàn, nhà phát triển cần thiết lập cơ chế kiểm soát bảo mật khi tích hợp AI, tinh chỉnh (fine-tune) mô hình để tăng khả năng chống tấn công “jailbreak”, đánh giá an ninh định kỳ (AI red-teaming) và thiết kế hệ thống hướng dẫn (system prompts) phù hợp với mục đích sử dụng cụ thể.

AI an toàn không chỉ là công nghệ, mà còn là trách nhiệm

Song song với những phát hiện mang tính cảnh báo của Microsoft, giới chuyên gia nhận định rằng, các kỹ thuật tấn công mới như Whisper Leak đang làm thay đổi cách thế giới nhìn nhận về mức độ an toàn của dữ liệu mã hóa. Từ trước đến nay, HTTPS được xem như “lá chắn thép” cho mọi giao tiếp trực tuyến, nhưng nghiên cứu mới đã cho thấy những kẽ hở hoàn toàn nằm ngoài nội dung dữ liệu, cụ thể là kích thước, tần suất và nhịp phản hồi của các gói tin mã hóa.

Đây là lời nhắc nhở mạnh mẽ rằng, bảo mật không chỉ nằm ở thuật toán mã hóa, mà còn ở hành vi và mẫu hình giao tiếp của hệ thống. Trong bối cảnh AI được tích hợp sâu rộng vào các mô hình kinh doanh, cơ quan chính phủ và dịch vụ công, những rủi ro này không còn mang tính lý thuyết. Chúng có thể ảnh hưởng trực tiếp đến quyền riêng tư cá nhân và vận hành của các tổ chức.

Sự xuất hiện của Whisper Leak cho thấy mối quan hệ giữa quyền riêng tư và công nghệ AI đang trở nên mong manh hơn bao giờ hết. Khi AI được tích hợp sâu vào đời sống - từ công cụ tra cứu, trợ lý ảo, đến hệ thống phân tích dữ liệu doanh nghiệp - việc bảo vệ kênh giao tiếp giữa người và máy trở thành ưu tiên hàng đầu.

Theo các chuyên gia, các mô hình AI hiện nay không chỉ cần “thông minh hơn”, mà còn phải “an toàn hơn”. Điều này đòi hỏi sự phối hợp giữa các nhà phát triển, cơ quan quản lý và cộng đồng nghiên cứu để xây dựng tiêu chuẩn bảo mật mới cho thời đại AI, nơi mà từng gói dữ liệu, từng tín hiệu mạng có thể tiết lộ nhiều hơn chúng ta nghĩ./.